NVIDIA presenta Arquitectura Hopper

Para impulsar la próxima ola de data centers de IA, NVIDIA anunció hoy su plataforma de computación acelerada de próxima generación con la arquitectura NVIDIA Hopper, que permite lograr un salto de rendimiento de orden de magnitud con respecto a su predecesora.

La nueva arquitectura lleva el nombre de Grace Hopper, una científica de computación pionera en Estados Unidos, y reemplaza a la arquitectura NVIDIA Ampere, que se presentó hace dos años.

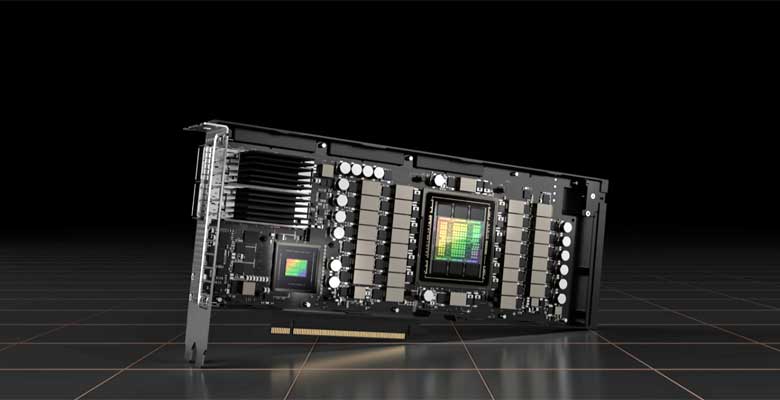

La empresa también anunció su primera GPU basada en Hopper, la NVIDIA H100, que cuenta con 80,000 millones de transistores. H100, el acelerador más grande y potente del mundo, cuenta con funciones revolucionarias, como un revolucionario motor de transformadores y una interconexión NVIDIA NVLink altamente escalable para procesar modelos gigantescos de lenguaje de IA, sistemas de recomendación profundos, genómica y digital twins complejos.

Innovaciones Tecnológicas de H100

La GPU NVIDIA H100 establece un nuevo estándar para acelerar la IA y la HPC a gran escala, lo que permite lograr seis innovaciones transformadoras:

- El Chip Más Avanzado del Mundo: H100 se diseñó con 80,000 millones de transistores con un proceso TSMC 4N de vanguardia, diseñado para las necesidades de computación aceleradas de NVIDIA. Ofrece importantes avances para acelerar la IA, la HPC, el ancho de banda de memoria, la interconexión y la comunicación, lo que incluye 5 terabytes por segundo de conectividad externa. H100 es la primera GPU compatible con PCIe Gen5 y la primera en utilizar HBM3, lo que permite un ancho de banda de memoria de 3 TB/s. Veinte GPU H100 pueden mantener el equivalente al tráfico de Internet de todo el mundo, lo que permite a los clientes ofrecer sistemas de recomendación avanzados y grandes modelos de idiomas que ejecutan inferencia en datos en tiempo real.

- Nuevo Motor de Transformadores: Transformer es uno de los modelos de deep learning más importantes de la historia, por lo que se convirtió en el modelo estándar para el procesamiento de idiomas naturales. El motor de Transformadores del acelerador H100 se construyó para acelerar estas redes hasta 6 veces en comparación con la generación anterior, sin perder un ápice de precisión.

- GPU de Múltiples Instancias Segura de 2da generación: La tecnología MIG permite dividir una sola GPU en siete instancias más pequeñas y completamente aisladas para manejar diferentes tipos de trabajos. La arquitectura Hopper extiende las capacidades de MIG hasta 7 veces en comparación con la generación anterior, al ofrecer configuraciones seguras de varios inquilinos en entornos de cloud.

- Computación Confidencial: H100 es el primer acelerador del mundo con capacidades de computación confidencial para proteger los modelos de IA y los datos de clientes mientras se procesan. Los clientes también pueden aplicar la computación confidencial al aprendizaje federado para industrias en las que la privacidad es importante, como el área de la salud y los servicios financieros, así como las infraestructuras de cloud compartidas.

- NVIDIA NVLink de 4.ª Generación: A fin de acelerar los modelos de IA más grandes, NVLink se combina con un nuevo NVLink Switch externo para extender NVLink como una red de escalabilidad vertical más allá del servidor. Esto permite conectar hasta 256 GPU H100 con un ancho de banda 9 veces más alto, en comparación con la generación anterior mediante NVIDIA HDR Quantum InfiniBand.

- Instrucciones de DPX: Las nuevas instrucciones de DPX aceleran la programación dinámica, que se usa en una amplia variedad de algoritmos, como la optimización de rutas y la genómica, hasta 40 veces en comparación con las CPU y hasta 7 veces en comparación con las GPU de la generación anterior. Esto incluye el algoritmo Floyd-Warshall, para encontrar rutas óptimas para flotas de robots autónomos en entornos dinámicos de almacenes, y el algoritmo Smith-Waterman, que se usa en la alineación de secuencias para la clasificación y el pliegue del ADN y las proteínas.

Las innovaciones tecnológicas combinadas de H100 extienden el liderazgo de NVIDIA en la inferencia y el entrenamiento de IA para permitir aplicaciones inmersivas y en tiempo real mediante modelos de IA a escala gigante. La H100 permitirá que los chatbots usen el modelo de lenguaje de transformadores monolíticos más potente del mundo, Megatron 530B, con una tasa de transferencia hasta 30 veces más alta que la generación anterior, al mismo tiempo que se cumple con la latencia de subsegundo necesaria para la IA conversacional en tiempo real. H100 también permite a los investigadores y desarrolladores entrenar modelos enormes como la Combinación de Expertos, con 395,000 millones de parámetros, hasta 9 veces más rápido, lo que reduce el tiempo de entrenamiento de semanas a días.