Intel presenta un enfoque definido por software y acelerado por silicio

Durante el segundo día de Intel Innovación 2023, Greg Lavender, Director de Tecnología de Intel, ofreció una visión detallada de cómo la filosofía de dar prioridad a los desarrolladores está contribuyendo a garantizar que las oportunidades de la inteligencia artificial (IA) sean accesibles para todos.

Los desarrolladores ansiosos por aprovechar la IA se enfrentan a obstáculos que obstaculizan la implementación generalizada de soluciones, desde clientes y bordes hasta centros de datos y la nube. Intel está comprometida a abordar estos desafíos con un enfoque definido por software y acelerado por silicio que se basa en los principios de apertura, elección, confianza y seguridad. Al proporcionar las herramientas que simplifican el desarrollo de aplicaciones de IA seguras y facilitan la inversión necesaria para mantener y escalar esas soluciones, Intel capacita a los desarrolladores para llevar la IA a todas partes.

Facilitando la Implementación de la IA con Confianza y Seguridad

Durante el discurso de apertura del Día 2 de Innovación, Lavender destacó el compromiso de Intel con la seguridad integral, que incluye la Cadena de Suministro Transparente de Intel para verificar la autenticidad del hardware y la computación confidencial para ayudar a proteger los datos confidenciales en uso. En la actualidad, Intel está ampliando la seguridad de su plataforma y la protección de la integridad de los datos con varias herramientas y servicios nuevos, incluido un nuevo servicio de certificación.

Este servicio, denominado Proyecto Amber, es el primero en un nuevo conjunto de software y servicios de seguridad llamado Intel Trust Authority. Ofrece una evaluación unificada e independiente de la integridad y la aplicación de políticas del entorno de ejecución confiable (TEE) y se puede utilizar en cualquier lugar donde se implemente la computación confidencial de Intel, ya sea en múltiples nubes, entornos híbridos, locales o en el borde. Intel Trust Authority también se convertirá en una capacidad integral para habilitar la IA confidencial, lo que ayudará a garantizar la confiabilidad de los entornos en los que se procesan datos y propiedad intelectual (PI) confidenciales en aplicaciones y modelos de aprendizaje automático, especialmente en inferencias en las generaciones actuales y futuras de procesadores Intel® Xeon®.

La IA es un motor de innovación con casos de uso en todos los sectores, desde la atención médica y las finanzas hasta el comercio electrónico y la agricultura.

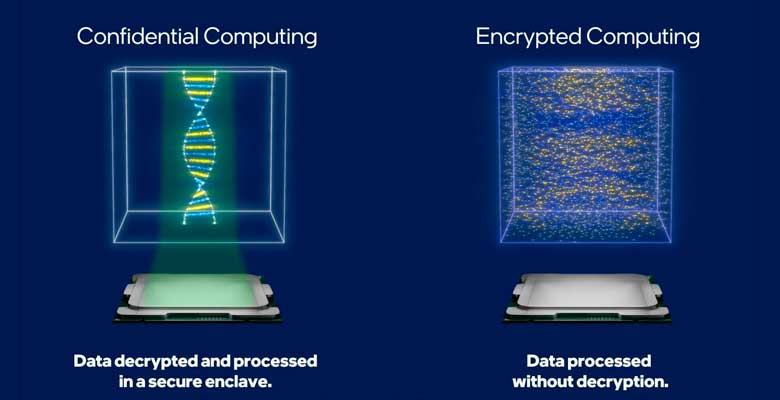

Conforme el mundo confía más en la IA para resolver problemas grandes y complejos y ofrecer resultados empresariales reales, crece la necesidad de proteger los modelos de IA, los datos y las plataformas en las que se ejecutan, contra la manipulación y el robo. El cifrado completamente homomórfico (FHE) permite realizar cálculos computacionales directamente sobre los datos cifrados, aunque las implementaciones prácticas están limitadas por la complejidad computacional y la sobrecarga.

Intel anunció hoy que está desarrollando un circuito integrado específico de la aplicación (ASIC) acelerador para reducir la inmensa sobrecarga de rendimiento asociada con un enfoque de FHE basado únicamente en software. Además, la empresa lanzará la versión beta de un conjunto de herramientas de software de computación cifrada, que permitirá a investigadores, desarrolladores y comunidades de usuarios aprender y experimentar con la codificación FHE. Esto estará disponible a finales de este año como parte de la Nube de Desarrollo de Intel®, cuya disponibilidad general se anunció ayer, e incluirá un conjunto de interfaces interoperables para desarrollar software FHE y herramientas de traducción.

Un Ecosistema Abierto con Rendimiento Optimizado Facilita la Elección

Organizaciones de todo el mundo están utilizando la IA para acelerar los descubrimientos científicos, transformar los negocios y mejorar los servicios al consumidor. Sin embargo, la aplicación práctica de las soluciones de IA se ve limitada por retos difíciles de superar, desde la falta de experiencia interna en las empresas y la insuficiencia de recursos para gestionar adecuadamente el pipeline de IA (incluida la preparación de datos y el modelado) hasta las costosas plataformas patentadas cuyo mantenimiento continuo es caro y requiere mucho tiempo.

Intel está comprometida con el desarrollo de un ecosistema abierto que facilite la implementación en múltiples arquitecturas. Esto incluye su participación en la Fundación de Aceleración Unificada de Linux (UXL), una iniciativa intersectorial dedicada a ofrecer un modelo abierto de programación de aceleradores que simplifique el desarrollo de aplicaciones para su implementación en diversas plataformas. La UXL representa una evolución de la iniciativa OneAPI. El modelo de programación oneAPI de Intel permite escribir el código una sola vez y desplegarlo en múltiples arquitecturas informáticas, incluidas CPU, GPU, FPGA y aceleradores. Intel contribuirá a la Fundación UXL con su especificación oneAPI para impulsar el desarrollo multiplataforma en todas las arquitecturas.

La empresa también colabora con los principales proveedores de software, como Red Hat, Canonical y SUSE, para proporcionar distribuciones optimizadas de sus soluciones de software empresarial, garantizando un alto rendimiento en las arquitecturas Intel más recientes. En el evento de Innovación, Lavender estuvo acompañado por Gunnar Hellekson, vicepresidente y gerente general de Red Hat Enterprise Linux (RHEL), para anunciar una colaboración ampliada que permitirá a Intel contribuir con soporte upstream para el ecosistema RHEL utilizando CentOS Stream. Intel sigue colaborando con herramientas y marcos de IA y aprendizaje automático, como PyTorch y TensorFlow.

Para ayudar a los desarrolladores a escalar el rendimiento de manera rápida y sencilla, Intel Granulate cuenta con una función de piloto automático para el redimensionamiento de recursos de pod en Kubernetes. Esta herramienta de optimización proporcionará recomendaciones automáticas y continuas de gestión de capacidad para los usuarios de Kubernetes, lo que les permitirá reducir la inversión necesaria para alcanzar sus objetivos de coste rendimiento en entornos contenerizados. Intel Granulate proporciona capacidades de orquestación autónoma para las cargas de trabajo de Databricks, lo que resulta en una reducción promedio del 30% en los costes y del 23% en el tiempo de procesamiento, sin cambios en el código.